SDSC6012

References

- Shumway, R. H., & Stoffer, D. S. (2017). Time Series Analysis and Its Applications : With R Examples (4th ed. 2017.). Springer International Publishing. https://doi.org/10.1007/978-3-319-52452-8

CityU library 可以下载PDF版本 点击直达

- Course SDSC6012 slides

- ChatGPT 4o

- My Thinking …

Lecture1

时间序列分析的目标:描述、预测、控制和假设检验

时序中的随机变量

- 随机变量: 随机变量

是一个函数,它将一个样本空间中的事件映射到实数(或其他数值)。其值是随机的,即它的取值受某个概率分布的控制 - 在时间序列分析中,随机变量

是指时间序列的每一个观察值,它在每个时间点上是随机的,并且其值遵循某个概率分布

Stochastic process 随机过程

按照时间索引的过程就是随机过程 - 是一种建模方法,研究不同时间点的关系

- The observed values of a stochastic process are referred to as a realization of the stochastic process. 也就是说,我们在某个时间序列中看到的数据只是随机过程的一个实现realization

- An observed time series is considered to be one realization of a stochastic process. 观测到的时间序列是随机过程的一种实现

什么叫“随机过程”?这个随机和random有关系吗?

GPT:

“随机过程”中的“随机”确实与“random”(随机)有关。它指的是一个随时间演变的系统或现象,其中的结果不是确定的,而是随机的。每个时刻的数据点(或状态)是由一组随机变量表示的。

具体来说,“随机过程”是指一个按时间顺序排列的随机变量集合,表示某个系统或现象在时间上的变化。由于这些随机变量的结果是不可预知的,所以我们说它是“随机”的。这与“random”一词的含义一致,指的是结果或状态是通过某种概率分布产生的,而不是确定的。

例如,股票价格、天气变化、人口增长等都可以用随机过程来描述。它们在不同时间点的值是由多个因素影响的,并且这些值无法完全预测,因此被视为“随机”的。

总结来说,随机过程是描述系统或现象如何在时间上以随机方式变化的数学模型,其中的“随机”与“random”密切相关,表示不确定性和概率性。

随机过程 vs. 随机变量:

在时间序列分析中,我们通常处理的是随机过程

换言之: 多个会变化的随机变量

,并且变化是以时间为维度的,就变成了随机过程

假设有一个随机过程

相关符号

随机过程 在随机过程 中的一个随机变量 是一个随机过程 中的一个观测值

White noise 白噪声

白噪声是一种随机信号,其中各个时间点上的值都是彼此不相关的,也就是这些随机变量之间没有相关性。

它的自相关函数是零,表示在不同时间点的信号是完全独立的。

Gaussian white noise 高斯白噪声

一种特殊的白噪声,保证噪声的分布满足正态分布

相关符号

白噪声 方差 白噪声 正态分布

Time series modeling 时间序列模型

时间序列模型的基本结构可以表示为:

其中:

表示时间序列的观测值;

注意是观测值, 这就是为什么是小x而不是大X

是趋势成分(trend component),表示时间序列的长期变化趋势; 是季节性成分(seasonal component),表示时间序列的周期性波动(如季节、月度变化等); 是残差(residual),表示无法通过趋势或季节性成分解释的随机噪声或误差, 例如 。

这个模型将时间序列分解为三个部分,以便更好地理解和预测时间序列的行为。

噪声属于什么部分?

GPT:

在时间序列模型中,噪声属于公式中的残差部分(residual),即

。残差代表的是时间序列中无法通过趋势( )和季节性成分( )解释的部分。 具体来说:

- 噪声(noise) 是指时间序列中由于随机因素产生的波动或误差,通常被视为不可预测的随机变化。

- 残差(residual) 是实际观测值与模型预测值之间的差异,包括噪声成分。

因此,在时间序列模型

中,噪声就是 ,它通常表示为服从某种概率分布的随机变量(如白噪声、高斯白噪声等),是建模过程中用来描述不规则波动的重要部分。

均值性质

- 均值具有线性性(线性性)

- 常数的期望即本身(常数性)

- 独立随机变量和的 均值 == 独立随机变量均值的 和 (独立性)

- 独立随机变量积的 均值 == 独立随机变量均值的 积 (独立性)

均值与随机过程

Moving Average Series

根据均值的线性性,可得:

性质:⽆论多少个⽆关噪声求和,期望都是0

Random Walk with Drift

注意这里

根据均值的线性性与常数型,可得

性质:在具有线性趋势的时间序列模型中,期望值反映的是时间序列的趋势部分,而不受随机噪声的影响

Signal Plus Noise

与上个Example一样,同样t也是看成常数

噪声不会影响时间序列的期望值

协方差

协方差的定义

协方差

和 分别是随机变量 和 的期望值 表示随机变量 偏离其期望值的程度 表示随机变量 偏离其期望值的程度 - 协方差实际上是对

和 这两个偏差的乘积的期望

均值的平方转换为方差/协方差

在

尤其在:

协方差的意义

- 如果协方差为正,意味着这两个变量趋向于同方向变化

- 如果协方差为负,意味着它们趋向于相反方向变化

- 如果协方差接近 0,意味着两个变量之间没有线性关系

协方差的性质

- 对称性

- 退化方差

方差是协方差的特例。当

- 缩放不变性

假设

这意味着,如果对一个随机变量进行线性变换,它的协方差会按比例缩放

同样的,常数不会影响协方差和的值

- 分配性质

对于三个随机变量

Autocovariance function 自协方差函数

用于衡量相关性

是用来衡量同一随机过程中不同时间点对应的随机变量之间的线性相关性

为什么时间点之间可以衡量协方差?衡量协方差不应该是利用随机变量,代表的是多个值吗?

虽然

和 表示的是时间点, 但是对于随机过程 来说, 和 代表的是 和 随机变量, 但是实际上我们关心的是 和 随机变量之间的协方差

- 当

代表无相关性 - 当

,协方差退化为方差

为什么当

,协方差退化为方差? 从公式理解:

从意义理解:

协方差衡量的是两个不同随机变量之间的关系。当我们讨论同一个随机变量的协方差(即

),这个度量变成了它自身随机变量的波动性,即方差

协方差与随机过程

Example1 - white noise

- 当

时, 方差退化成协方差

- 当

时, 由于白噪声在不同时间点中是互相独立的

或者我们利用公式推导:

由于

,

Example2

根据缩放不变形,各提取

根据协方差的分配性质

这是一个对所有组合

由 Example1 我们知道, 对于白噪声, 任意不同时刻的协方差都为0, 换言之, 在所有组合中, 只有时间相等的协方差为非0, 且为

- 当

时

- 当

时

- 当

时

综上:

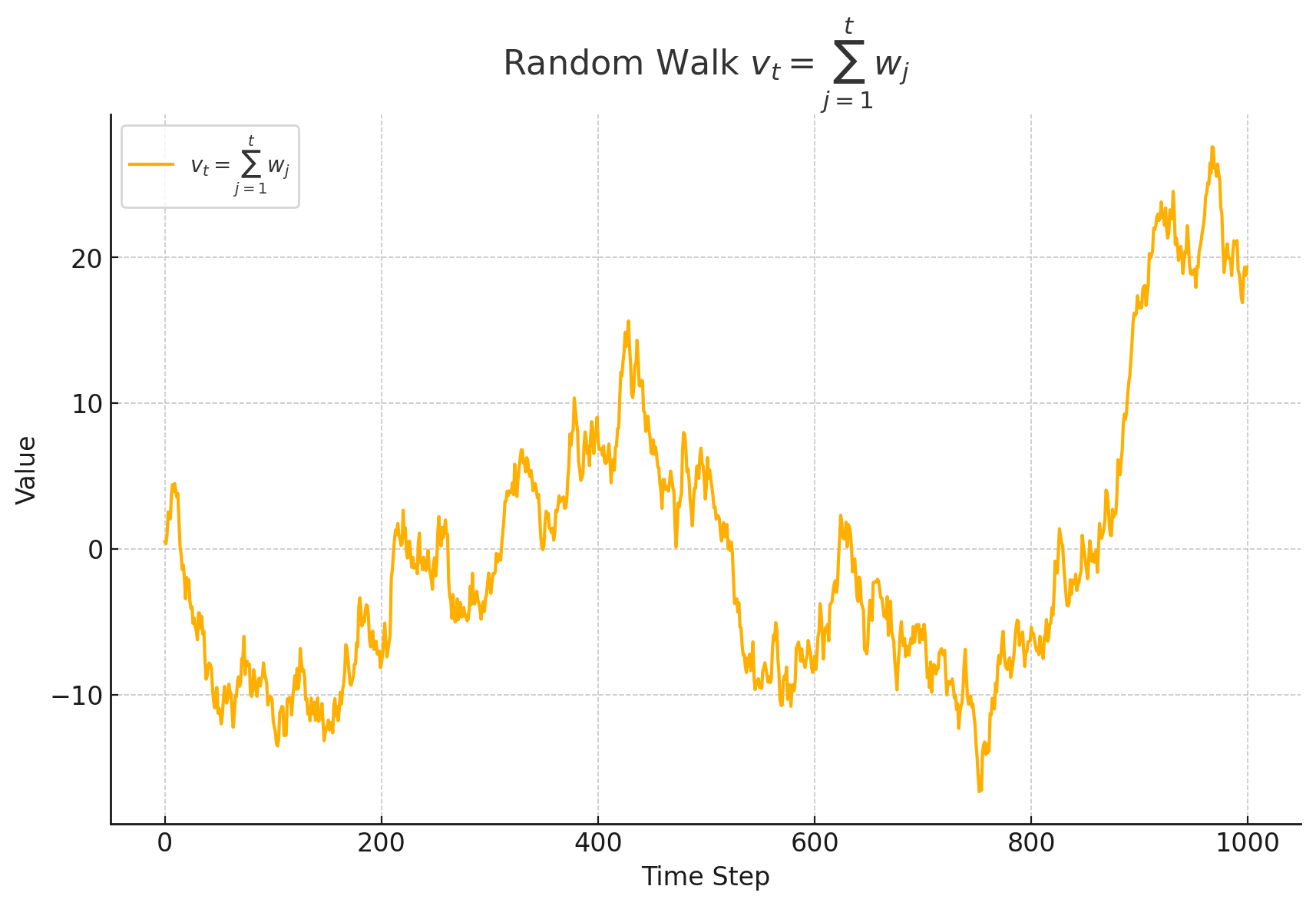

Example3 - random walk

由 Example2 我们知道, 要求多个白噪声对应随机变量的协方差, 只需要看在数轴上重合了多少个点

直观理解 随机游走 random walk :

某个变量(如价格、位置等)从一个初始点开始,每一步都根据一个随机增量进行更新。这个增量可能是正的也可能是负的,因此随机游走的轨迹看起来像是一条无规则的曲线。

随机游走的方差随着时间增加而增大。因此,随机游走的统计特性不是恒定的。

Lecture2

Strict stationarity 严格平稳性

定义:当满足

有相同的联合分布的时候,时间序列

通常利用公式:

来表示。

这种时间平移不影响联合分布的性质,这也意味着时间序列的所有统计特性(如均值、方差、协方差等)不会随着时间的变化而改变。

为什么

中仅仅要求“小于某个值 ”? GPT:

这是因为在概率论中,事件通常是用不等式表示的。比如说,表示随机变量xt,落在某个范围之内的概率,我们通常用

这样的不等式来描述。它表示“时间点 处的随机变量 ,小于等于 的概率“。类似地,公式中表达的是多个随机变量同时满足某些不等式的概率。 对于严格平稳性来说,关心的是这些随机变量在不同时间点是否有相同的联合分布。通过不等式

,我们可以测量在多个时间点上这些变量同时满足条件的概率。如果这些概率在任何时间偏移 下都相等,那么我们就说这个时间序列是严格平稳的。

为什么严格平稳性是要求联合分布的概率相同,⽽不是⽅差和均值?

GPT:

严格平稳性要求联合分布的概率相同,而不仅仅是均值和方差相同,是因为它关注随机过程的完整统计特性。均值和方差只是部分特征,无法完全描述过程的行为,而联合分布包含了所有可能的统计信息,确保了过程在时间上的一致性。严格平稳性因此为分析和预测随机过程提供了一个更强大和全面的框架。

严格平稳性和相关性的关系:

推导过程:从多维联合分布到二维联合分布(

Weak stationarity 弱平稳性

与严格平稳性相比,弱平稳性对时间序列的约束条件较少,而不需要每个时间点的联合分布都保持不变。

定义:时间序列

- 均值独立于时间

- 协方差只依赖于时间间隔

自协方差函数

假设时间序列是平稳的

公式定义:

其中:

是时间差(lag),表示两个时刻之间的时间间隔 是时间序列的均值,假设时间序列是弱平稳的(均值不随时间变化)

协方差永远不可能与自己的协方差(方差)更大, 换言之自己与自己的相关性永远更大 由于协方差性质 ,可得自协方差具有对称性

时间序列乘积转换为

时间序列

在PACF的时候会利用这个公式

Autocorrelation Function 自相关函数 ACF

定义:

随机过程

为什么不是

? 从公式上看,

后面的 已经带了 从定义上看,由于我们假定了随机过程满足平稳性,自协方差函数只依赖于时间滞后

,而不是具体的时刻

由性质

平稳性、ACF与随机过程

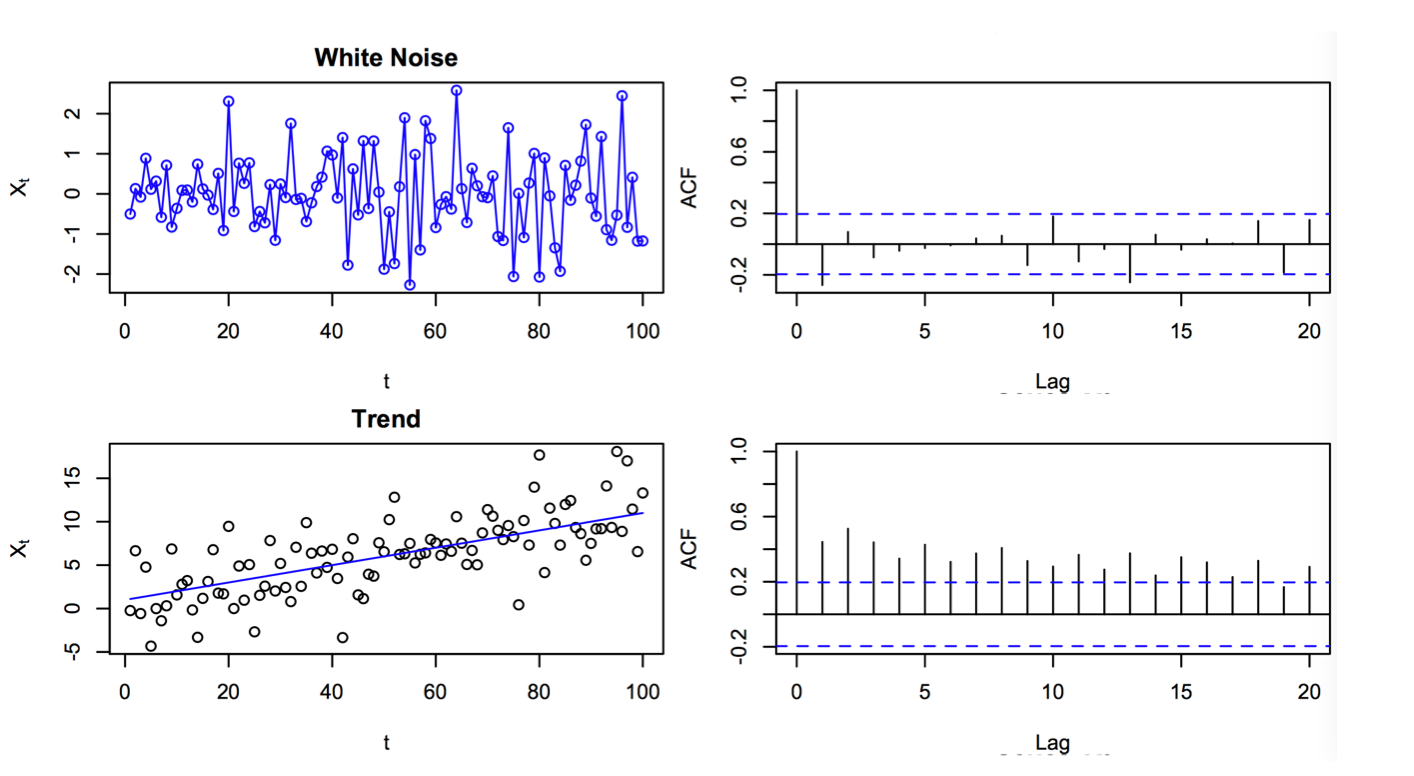

white noise

Step1: 考察方差是否独立于

Step2: 考察协方差是否只依赖于时间间隔

由 随机噪声协方差 的性质我们知道:

故白噪声

我们可以得到ACF图像

random walk

Step1: 考察方差是否独立于

Step2: 考察协方差是否只依赖于时间间隔

由于随机游走的协方差依赖与

MA(1) process

MA(1) process (moving average)

Step1: 考察方差是否独立于

Step2: 考察协方差是否只依赖于时间间隔

由 白噪声的协方差性质 可得:当时间相同时,协方差为

- 当

时:

- 当

或 时:

- 当

综上

故 MA(1) process 是弱平稳的

知识补充:无穷级数

对于无穷级数

当

- 假设级数的和为

- 将该表达式乘以

- 将 S 和 rS 相减,并提取公因子

- 解得 S

知识补充:几何级数

AR(1) process

AR(1) process (autoregressive)

先展开递归公式:

Step1: 考察方差是否独立于

易得:

Step2: 考察协方差是否只依赖于时间间隔

- 当

时:

在连续求和中,由于协方差的分配性质,前一个求和项都会后一个求和项形成组合,只有下标相等的为非0项,得到

利用无穷级数:

- 当

时, :

对于

即

可得

由于白噪声在时间

故 AR(1) process 是弱平稳的

相关性估计

对于观测值

方法:

- 计算均值

- 利用滑动窗口思想,将窗口中的

和 为一组送入公式求出协方差

- 计算ACF

由于

,所以对于确定满足弱平稳性的随机过程来说在 和 上是对称的

对于观测值来说,均值为

结论:当

Why这个公式?详细请GPT……

利用ACF判断白噪声

白噪声的

这说明当样本量较大时,自相关系数估计量会趋于类正态分布(AN)

意味着可以利用正态分布的性质来推断这些估计值是否为白噪声

样本ACF可以帮助我们识别许多非白噪声(甚至非平稳)时间序列

样本ACF可以帮助我们识别许多非白噪声(甚至非平稳)时间序列

Backshift and forward-shift operator

Backshift operator:

Forward-shift operator:

First difference operator:

Differences with order d:

差分

对于时间序列模型的基本结构

The first difference eliminates a linear trend 一阶差分消除了线性(一次)趋势:

eg:

The second order difference eliminates a quadratic trend 二阶差分消除了二次趋势:

eg:

求二阶差分的方法是先求出一阶差分,对于一阶差分的表达式再求一次差分

如果我们想要去除季节项

季节的时间差为

Lecture3 / Lecture4

Linear process

Linear process(线性过程) 是时间序列分析中的一个基本概念,用于描述当前时间序列值与过去白噪声项的线性组合

Linear process 的分布为:

我们知道

平稳的时间序列在进行线性变化后也是平稳的,同样的将一个平稳的随机过程作用于线性过程中,整个线性过程也会保持平稳

AR(p)

假设当前值和过去值之间存在关系,当前时间

用数学表示为:

同时:

也可以形式表示为:

利用Backshift operator表示为:

Mean and autocovariance function:

详情请搜索Yule-Walker方程及矩阵

AR(1) model

当 Autoregressive models

根据 AR1 平稳性推理的结论,我们知道:

将

感受递归推导的复杂性, 这也是为什么我们要引入Backshift op来简化计算

Mean and autocovariance function:

In terms of the backshift operator:

Linear process 表示:

注意

Explosive AR Models and Causality

As AR(1) process with

We can, however, modify that argument to obtain a stationary model as follows. Write

which means the process is stationary, but it is also future dependent.

When a process does not depend on the future, such as the AR(1) when

判断 AR(n) Causality 的方法

写成Autoregressive operator:

写出特征方程:

我们解出所有的解析解,如果所有的解都满足

怎么理解解析解都必须大于1?

不知道,还在想....

Every Explosion Has a Cause

必须理顺各种表达形式:

- autoregressive operator:

- MA(

) Representation:

结论:

Why?观察公式:

易证

推导的核心就是将

Coefficient of:

: : : :

简单来说,依次找

MA(q)

Moving average operator:

Mean and autocovariance function:

MA(1)

将

易得: Mean, autocovariance, and autocorrelation function:

先移项,然后按照类似于AR(1)的方法

递归展开,得到

易证:

Non-uniqueness of MA Models and Invertibility

对于MA模型来说, 可能会出现这种情况:

We note that for an MA(1) model,

对于拥有观测值并尝试预测模型来说,这是一种灾难,因为同样的数据有可能会出现两个模型都匹配; 因此我们需要挑选出一个模型: We will choose the model with an infinite AR representation. Such a process is called an invertible(可逆) process.

换言之, 我们挑选出的MA模型必须可以转换为AR模型

从公式角度上看, 例如MA(1),

判断 MA(q) Invertibility 的方法

对于一个 MA(q) 模型:

其中

得到

根据特征方程的根来判断:

- 如果特征方程的根模都大于1,则该 MA 模型是可逆的 (Invertible)。

- 如果某些根模小于或等于 1,则该 MA 模型是不可逆的 (Non-invertible)。

与

Lecture5

ARMA(p,q)

Avoid parameter redundancy

为了确保 ARMA 模型是最佳的表达形式,并避免使用不必要的参数,AR 部分和 MA 部分的多项式必须是互质的(没有共同因子)

example:

假设:

对应的 AR 多项式和 MA 多项式分别是:

我们可以通过除去这个公因子来简化模型。原本的 ARMA(2,1) 模型实际上可以简化为一个 ARMA(1,0) 模型(即一个 AR(1) 模型)

Stationarity

If

Causality

The ARMA(p,q) process is causal if and only if all the roots of

Invertibility

The ARMA(p,q) process is invertible if and only if all the roots of

Example of Stationarity, Causality, Invertibility

Step1: 移项AR的

注意移项的时候不要弄错符号!

Step2: 写出求根公式,进行因式分解

得:

注意: 由于我们需要Avoid parameter redundancy, 对于相同的因式需要消除

Step3: 进行Causal 和 Invertible 的判断

The roots of

The roots of

Convert to MA process

For a causal ARMA(p,q) model, we may write:

can use matching coefficients to find

Example: convert ARMA to MA:

Coefficient of:

: : : :

ARMA 的自相关函数

方法1: convert ARMA to MA

方法2: 利用

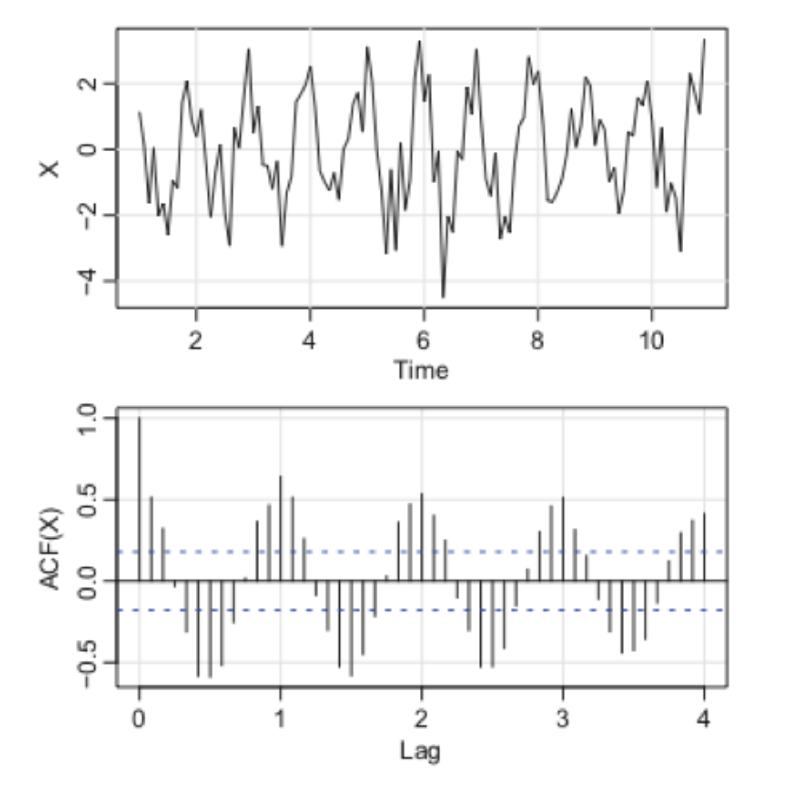

PACF

引入 PACF 的核心动机是为了克服 ACF 在分析 AR 或 ARMA 模型时的局限性:

- For MA(q) models, the ACF will be zero for lags greater than q, and will not be zero at lag

. - For ARMA(q) models, the diagram of ACF will appear Tails off, a gradual decay in the autocorrelation values over time lags.

For example,

为什么对于

也要减去 , 是发生在 之前的,理论上应该是无关的!? 虽然 在时间上发生在 之前,但由于 作为 的一个线性预测变量存在, 和 的相关性并非独立的,而是通过 这个中介变量传递。为了消除这种中介效应,我们通过去除 对 和 的影响来部分掉这个线性关系,这就是“将 进行协方差分析”的原因。这一步骤的目的是破除依赖链,从而仅考察与白噪声 w_t 的直接相关性。

Definition:

对于

“解除依赖项”是

和 中间的元素!

The partial autocorrelation function (PACF) of a stationary process,

注意这里是

而不是 , 这里是 而不是 !

参考

我们可以得到

PACF of an AR(1)

Consider the PACF of the AR(1) process given by

By definition,

利用

这个性质

二次方程的最优化问题利用求导找零点即可解决

为什么要进行minimize? 以AR(1)举例: 我们的目的是 将

去除 的影响, 从而实现更高的独立性 而 是由 通过某种“变化”而来,用公式表示为 , 我们求 本质上就是在逼近这个 , 尽可能去除 而保留 , 从公式来看就是 所以我们可以看到,在AR(1)最小化问题中, 最终是等于 的,但是在更加复杂的AR模型中,我们就需要利用minimize来求解!

Hence,

Thus,

PACF of an Invertible MA(q)

For an invertible MA(

For an MA(1),

ACF & PACF for models

| AR( | MA( | ARMA( | |

|---|---|---|---|

| ACF | Tails off | Cuts off after lag | Tails off |

| PACF | Cuts off after lag | Tails off | Tails off |

Lecture 6 / 7 /8

Forecasting

目标 Objective:

Predict future values of a time series,

Mean square error (MSE):

其中

Minimum mean square error (MSE) predictor:

换言之,对于MSE误差来说来说,条件期望(是一个函数)是最优的函数,可以达到“minimum MSE”

基于 infinite past 的预测,通常不会写成

,而是直接用条件期望的表示形式来表达预测值

Minimum mean square error (MSE)

证明待补充,还没看懂

Linear predictor

Predictors of the form:

Given data

- if

, then is the one-step-ahead linear forecast of given - if

, is the one-step-ahead linear forecast of given and . - In general, the

s in and will be different.

Best linear predictors (BLPs) for Stationary Processes

对于MSE的minimize,我们只需要对变量求导并求出零点即可

对于BLPs,我们需要调整

Minimize

Assume

We generally consider

when

Hence, the form of the BLP is

One-step ahead prediction

The BLP of

Using BLPs' s minimize property:

注意写成

而不是 主要是展开后可以很方便写成 形式:

matrix form:

notation as:

where

- is a positive definite matrix 是正定矩阵

- is a non-singular matrix 是非奇异矩阵(只有一个解) where

: is an vector is an vector is an vector is an vector

正定矩阵作用:

- 有唯一的最小值,其导数也是正定的,可以通过求导进行优化

- 可以进行内积,

正定矩阵

的判别:

- 利用二次型

恒大于0 - 特征值都大于0

- 各阶顺序主子式都大于0

It is sometimes convenient to write the one-step-ahead forecast in vector notation

where:

is an vector

不加

的都是列向量,反之是行向量

The mean square one-step-ahead prediction error is:

Prediction for an AR(2)

AR2:

The one-step-ahead prediction of

or:

As for AR(2), it should be apparent from the model that

If the time series is a causal AR(

Durbin–Levinson Algorithm

Computes

For

For

example - Using the Durbin–Levinson Algorithm

To use the algorithm, start with

For

For

and so on. Note that, in general, the standard error of the one-step-ahead forecast is the square root of

example - The PACF of an AR(2)

AR2:

In fact, in AR(p) model, because of the property of Prediction for an AR(2),

This result shows that for an AR(

可以说 AR模型的Linear predictor 就是AR模型本身

The Innovations Algorithm

The one-step-ahead predictors,

where, for

Given data

where the

example - Prediction for an MA(1)

The innovations algorithm lends itself well to prediction for moving average processes.

MA(1):

Using Innovations Algorithm:

Finally, the one-step-ahead predictor is

Forecasting ARMA models

Forecasting AR(p) and MA(q)

- The Durbin-Levinson algorithm is convenient for AR(p) processes

- The innovations algorithm is convenient for MA(q) processes.

Review causality and invertibility

因果性(Causality):指的是当前值

仅依赖于当前及之前的随机扰动项(白噪声项) ,而不依赖未来的 。这就意味着,对于未来的时刻 ,我们对 的条件期望 应该是零 可逆性(Invertibility):指的是可以将当前的白噪声项

用过去的观测值 表示出来。这表明,对于任何过去的扰动项 (其中 ),我们可以通过过去的观测值来估计或重构 ,因此条件期望

Thus:

Forecasting ARMA Processes

We assume

First, we consider two types of forecasts. We write

For ARMA models, it is easier to calculate the predictor of

In general,

Now, write

将公式(3.82)中

由于期望的线性性质,可以将求和符号和常数

根据性质 (3.81) 对于

Similarly, taking conditional expectations in (3.83), we have

Using (3.82) (3.84), we can write

so the mean-square prediction error can be written as

Long-Range Forecasts

Replacing

Noting that the

exponentially fast (in the mean square sense) as

Moreover, by (3.86), the mean square prediction error

exponentially fast as

It should be clear from (3.89) and (3.90) that ARMA forecasts quickly settle to the mean with a constant prediction error as the forecast horizon,

Truncated Prediction for ARMA

截断预测是一种用于时间序列分析的方法,指的是在模型预测未来值时,因为只能利用有限的历史数据而无法观测无限的过去数据,或者无法利用未来的观测值,因此对模型的计算进行简化和近似

ARMA模型:

- 我们仅有数据

- AR 部分的回归结构(依赖于过去的

)天然支持递归预测 - 对于

或 ,设 ,因为这些噪声项不可观测 此时,截断预测通过以下假设简化计算: - 假设未知噪声项

(对于 or ) - 递归地使用过去的预测值代替未来的未知值。

The truncated prediction formula is given as:

Where:

: - for (observed values). - for (before the start of the series). - Truncated prediction errors

: - for or (unobserved noise outside the series range). - For , is calculated as:

Example to drive MMSE predictor and its MSE

Example1

MA(1)

对于一般的MA模型,我们并不使用Durbin–Levinson Algorithm和The Innovations Algorithm,而使用定义求解

Minimum mean square error (MSE) predictor:

解:

上面的过程是错误的,我们需要将预测公式写成已知观测值的形式,而

根据 MA(1) 模型定义:

将

代入

取条件期望:

MSE:

Example2

For an AR(1) model, determine the general form of the

AR(1) Model:

Mean Squared Error (MSE):

Estimation

We assume

- we have

observations, - from a causal and invertible Gaussian ARMA(

) process - The data has zero mean

Our goal is

- estimate the parameters,

, and - determining

and later in this section.

Yule-Walker estimation

Yule-Walker 方程是自回归模型(AR 模型)参数估计的一种方法,基于样本自协方差和理论自协方差的一致性。

对于

是需要估计的参数; 是零均值白噪声,具有方差

其矩阵Yule-Walker形式如下

具体展开形式 假设

For MA and ARMA models, the Yule–Walker estimators are not optimal

BLPs 中也使用了Yule–Walker estimators 的矩阵来估计Linear predictor 的参数,但是目标是不一样的。BLPs目标是通过观测值预测未来,而Yule–Walker estimators用于估计求参数

在计算 Yule-Walker 方程时,直接求解线性方程组

Maximum likelihood estimator

Assume {

For the causal AR(1) model, the process is defined as:

Since

where

Final Likelihood The likelihood can be written as:

we see that

Full Likelihood Function The likelihood for the AR(1) process is:

where:

For a normal ARMA(p,q) model, the likelihood expression can be simplified in terms of the innovations

- Model parameters:

- Likelihood function:

The conditional distribution of

L(\beta, \sigma_w^2) = (2\pi \sigma_w^2)^{-n/2} \left[ r_1(\beta) r_2(\beta) \cdots r_n(\beta) \right]^{-1/2} \exp \left[ -\frac{S(\beta)}{2 \sigma_w^2} \right]

S(\beta) = \sum_{t=1}^n \left[ \frac{\left( x_t - x_t^{-1}(\beta) \right)^2}{r_t(\beta)} \right]

\begin{pmatrix} \hat{\phi} \ \hat{\theta} \end{pmatrix} - \begin{pmatrix} \phi \ \theta \end{pmatrix} \sim AN \left( 0, \frac{\sigma_w^2}{n} \begin{pmatrix} \Gamma_{\phi\phi} & \Gamma_{\phi\theta} \ \Gamma_{\theta\phi} & \Gamma_{\theta\theta} \end{pmatrix}^{-1} \right),

\text{Var}(\hat{\phi}_1) \approx \frac{1 - \phi_1^2}{n}.

\text{Var}(\hat{\phi}_1) \approx \frac{1 - \phi_2^2}{n} = \frac{1}{n}.

\nabla^d x_t = (1 - B)^d x_t

\phi(B)(1 - B)^d x_t = \theta(B)w_t, \tag{3.144}

e_t = \frac{x_t - \hat{x}_t^{-1}}{\sqrt{\hat{P}_t^{-1}}}

Perform diagnostics:

- Check the residuals to ensure they resemble white noise.

- Evaluate model fit and adjust as necessary.

Model selection:

- Compare different models using criteria such as Akaike Information Criterion (AIC) or Bayesian Information Criterion (BIC).